Cadenas de Markov: Guía Completa y Práctica para Entenderlas Fácilmente

Las Cadenas de Markov representan uno de los conceptos más importantes y versátiles en probabilidad y estadística moderna. Estos modelos matemáticos permiten describir procesos aleatorios en los cuales el próximo estado del sistema depende únicamente del estado actual, sin importar los eventos pasados. Esta característica, conocida como propiedad de Markov, hace que estos modelos sean extremadamente útiles para analizar fenómenos complejos que evolucionan con el tiempo pero mantienen una "memoria limitada".

En este artículo, exploraremos en profundidad el fascinante mundo de las Cadenas de Markov, desde sus fundamentos teóricos hasta sus diversas aplicaciones prácticas. Veremos cómo estos modelos se han convertido en herramientas fundamentales en campos tan diversos como la inteligencia artificial, las finanzas, la bioinformática, y la optimización de motores de búsqueda. Ya sea que seas estudiante, investigador o profesional en ciencia de datos, comprender las Cadenas de Markov te proporcionará una poderosa perspectiva para modelar y predecir comportamientos probabilísticos en sistemas complejos.

- ¿Qué son las Cadenas de Markov?

- Conceptos Fundamentales de las Cadenas de Markov

- Tipos de Cadenas de Markov

- Componentes de un Modelo de Markov

- Cálculo de Probabilidades y Matrices de Transición

- Análisis a Largo Plazo de las Cadenas de Markov

- Aplicaciones Prácticas de las Cadenas de Markov

- Herramientas y Bibliotecas de Software para Cadenas de Markov

- Ejemplos Resueltos de Cadenas de Markov

- Conclusión

- Preguntas Frecuentes

¿Qué son las Cadenas de Markov?

Cómo Resolver Cadenas de Markov en Estado Estable: Guía Paso a Paso

Cómo Resolver Cadenas de Markov en Estado Estable: Guía Paso a PasoLas Cadenas de Markov son modelos probabilísticos que describen la transición entre diferentes estados. Imagina un juego de mesa donde tu posición actual en el tablero depende únicamente de la casilla en la que estabas en el turno anterior, sin importar cómo llegaste a esa casilla. Este sencillo ejemplo encapsula la esencia de una Cadena de Markov. Formalmente, una Cadena de Markov es una secuencia de variables aleatorias donde la probabilidad de cada variable depende solo de la variable anterior. Esta "falta de memoria" es la característica definitoria de estos modelos.

La clave para entender las Cadenas de Markov reside en la "propiedad de Markov", también conocida como propiedad de "memoria limitada" o "sin memoria". Esta propiedad establece que, para predecir el futuro estado de un sistema modelado por una Cadena de Markov, solo necesitamos conocer su estado presente. El pasado, es decir, la secuencia de estados que llevaron al estado actual, es irrelevante. Esta simplificación, aunque pueda parecer restrictiva, resulta sorprendentemente poderosa y permite modelar una amplia gama de fenómenos complejos.

Objetivos y aplicaciones de las Cadenas de Markov

Las Cadenas de Markov no son solo un concepto teórico abstracto; son herramientas increíblemente prácticas con una amplia gama de aplicaciones. Su principal objetivo es modelar sistemas que evolucionan a través del tiempo, pasando por diferentes estados, donde las transiciones entre estados tienen una naturaleza probabilística y cumplen con la propiedad de Markov. Esta capacidad para modelar sistemas dinámicos las convierte en indispensables en muchos campos.

Predicción a Corto Plazo con Cadenas de Markov: Una Guía Paso a Paso

Predicción a Corto Plazo con Cadenas de Markov: Una Guía Paso a PasoUna de las aplicaciones más conocidas y exitosas de las Cadenas de Markov es el algoritmo PageRank de Google. Este algoritmo, que revolucionó la búsqueda en internet, utiliza una Cadena de Markov para determinar la importancia de las páginas web. Imagina navegar por la web haciendo clic aleatoriamente en los enlaces. PageRank modela este proceso como una Cadena de Markov, donde cada página web es un estado y la probabilidad de transición entre páginas está determinada por los enlaces. Las páginas más importantes, aquellas a las que se llega con mayor probabilidad siguiendo este "navegador aleatorio", obtienen una mayor puntuación de PageRank y, por lo tanto, se muestran en los primeros resultados de búsqueda.

Además de Google PageRank, las Cadenas de Markov se utilizan en:

- Reconocimiento de voz: Modelan las secuencias de fonemas en el habla para mejorar la precisión del reconocimiento.

- Finanzas y trading: Para modelar el comportamiento de los precios de acciones y otros activos financieros, aunque con limitaciones debido a la naturaleza compleja y a veces impredecible de los mercados.

- Bioinformática: En el análisis de secuencias de ADN y proteínas, para identificar patrones y predecir la estructura y función de las biomoléculas.

- Sistemas de recomendación: Como en Spotify o Netflix, para predecir las preferencias de los usuarios basándose en su historial de consumo y recomendar contenido relevante.

- Predicción del tiempo: Modelos meteorológicos utilizan Cadenas de Markov para predecir la evolución del tiempo, aunque los modelos modernos son mucho más sofisticados.

- Análisis del comportamiento del consumidor: Para predecir patrones de compra y preferencias de los clientes.

- Procesamiento del lenguaje natural: En tareas como la corrección ortográfica, la traducción automática y la generación de texto.

- Redes sociales: Para analizar la propagación de información y la dinámica de las redes sociales.

- Inventario y logística: Para optimizar la gestión de inventarios y la planificación logística, prediciendo la demanda y optimizando rutas.

- Control de calidad: En la industria manufacturera, para modelar la probabilidad de que un producto pase o falle diferentes pruebas de calidad en cada etapa del proceso de producción.

Esta lista, aunque extensa, solo araña la superficie de las aplicaciones de las Cadenas de Markov. Su versatilidad y capacidad para modelar sistemas dinámicos con incertidumbre las convierten en una herramienta esencial en la ciencia y la ingeniería moderna.

Guía Completa para Resolver Problemas de Estados Absorbentes en Cadenas de Markov

Guía Completa para Resolver Problemas de Estados Absorbentes en Cadenas de MarkovBreve historia y origen de las Cadenas de Markov

Las Cadenas de Markov llevan el nombre del matemático ruso Andréi Markov, quien las introdujo a principios del siglo XX. En 1906, Markov publicó su primer trabajo sobre lo que hoy conocemos como Cadenas de Markov, titulado "Extension of the limit theorems of probability theory to a sum of variables connected in a chain". En este trabajo, Markov estudió una Cadena de Markov para modelar la alternancia de vocales y consonantes en el texto ruso, inspirándose en un análisis estadístico de la novela "Eugene Onegin" de Alexander Pushkin.

El trabajo de Markov fue innovador porque extendió la teoría de probabilidad a secuencias de eventos dependientes. Antes de Markov, la teoría de probabilidad se centraba principalmente en eventos independientes. La introducción de la propiedad de Markov permitió a los matemáticos modelar sistemas más realistas y complejos, donde los eventos estaban interconectados en el tiempo.

Aunque el trabajo inicial de Markov se centró en aplicaciones lingüísticas, el potencial de las Cadenas de Markov como herramienta general de modelado no tardó en ser reconocido. A lo largo del siglo XX, las Cadenas de Markov encontraron aplicaciones en física, biología, economía y, más recientemente, en informática e inteligencia artificial. Hoy en día, las Cadenas de Markov son una piedra angular de la teoría de la probabilidad y el modelado estocástico, con un impacto profundo y duradero en la ciencia y la tecnología.

Conceptos Fundamentales de las Cadenas de Markov

Para comprender a fondo las Cadenas de Markov, es crucial familiarizarse con algunos conceptos fundamentales. Estos conceptos son los bloques de construcción que nos permiten definir, analizar y aplicar estos modelos.

Estado de Markov y la propiedad de memoria limitada

El concepto central de una Cadena de Markov es el "estado". En el contexto de un modelo de Cadena de Markov, un estado representa una situación o condición específica en la que puede encontrarse un sistema en un momento dado. Los estados deben ser mutuamente excluyentes y colectivamente exhaustivos, lo que significa que el sistema siempre debe estar en exactamente un estado en cualquier momento dado, y el conjunto de todos los posibles estados debe cubrir todas las situaciones posibles del sistema.

Volviendo al ejemplo del juego de mesa, cada casilla del tablero puede considerarse un estado. Si estamos modelando el clima, los estados podrían ser "soleado", "lluvioso" o "nublado". En el caso del algoritmo PageRank, cada página web es un estado. La naturaleza de los estados depende completamente del sistema que estamos modelando.

La propiedad de "memoria limitada", o propiedad de Markov, se define formalmente como:

P(Xt+1 = sj | Xt = si, Xt-1 = sk, ..., X0 = sl) = P(Xt+1 = sj | Xt = si)

Donde:

- Xt representa el estado del sistema en el tiempo t.

- si, sj, sk, sl representan posibles estados del sistema.

- P(A|B) denota la probabilidad condicional de que ocurra el evento A dado que el evento B ha ocurrido.

En palabras más sencillas, esta ecuación matemática formaliza la idea de que la probabilidad de pasar al estado sj en el siguiente paso (tiempo t+1), dado que actualmente estamos en el estado si (tiempo t), depende únicamente del estado actual si y no de la historia de estados anteriores (Xt-1, Xt-2, ..., X0). En otras palabras, el futuro es independiente del pasado, dado el presente.

Esta propiedad de "memoria limitada" simplifica enormemente el modelado de sistemas dinámicos. En lugar de tener que rastrear toda la historia del sistema, solo necesitamos conocer su estado actual para predecir su futuro comportamiento probabilístico.

Probabilidad de transición y cómo se calcula

La probabilidad de transición es un concepto clave para cuantificar las Cadenas de Markov. Representa la probabilidad de moverse de un estado a otro en un solo paso de tiempo. Formalmente, la probabilidad de transición del estado si al estado sj se denota como Pij y se define como:

Pij = P(Xt+1 = sj | Xt = si)

Esta probabilidad representa la proporción de veces que el sistema se mueve del estado si al estado sj en un solo paso. Las probabilidades de transición son fundamentales para definir completamente una Cadena de Markov.

¿Cómo se calculan las probabilidades de transición en la práctica? La forma más común es a partir de datos históricos. Si tenemos datos sobre la secuencia de estados a lo largo del tiempo, podemos estimar las probabilidades de transición contando las frecuencias de las transiciones entre estados.

Por ejemplo, imagina que estamos modelando el clima con tres estados: "soleado", "nublado" y "lluvioso". Supongamos que tenemos datos históricos de los últimos 100 días. Contamos el número de veces que el clima pasó de "soleado" a "soleado", de "soleado" a "nublado", de "soleado" a "lluvioso", y así sucesivamente para todas las posibles transiciones. Si, por ejemplo, observamos que de 30 días soleados, 15 permanecieron soleados al día siguiente, 10 se volvieron nublados y 5 se volvieron lluviosos, entonces las probabilidades de transición desde el estado "soleado" serían aproximadamente:

- P(soleado -> soleado) = 15/30 = 0.5

- P(soleado -> nublado) = 10/30 ≈ 0.33

- P(soleado -> lluvioso) = 5/30 ≈ 0.17

Es importante notar que, para cada estado de origen (si), la suma de las probabilidades de transición a todos los posibles estados de destino (sj) debe ser igual a 1. Esto se debe a que desde cualquier estado, el sistema debe moverse a algún estado en el siguiente paso. En nuestro ejemplo del clima, 0.5 + 0.33 + 0.17 = 1 (aproximadamente).

Matriz de transición: Definición y cómo se utiliza

Una herramienta muy útil para representar las probabilidades de transición en una Cadena de Markov es la matriz de transición. La matriz de transición, a menudo denotada como P, es una matriz cuadrada donde la entrada (i, j) representa la probabilidad de transición Pij del estado i al estado j.

Si tenemos n estados posibles, la matriz de transición será una matriz de tamaño n x n. Por ejemplo, para nuestro modelo climático con tres estados ("soleado", "nublado", "lluvioso"), la matriz de transición podría ser:

Soleado Nublado Lluvioso

Soleado 0.5 0.33 0.17

Nublado 0.2 0.6 0.2

Lluvioso 0.1 0.4 0.5

En esta matriz, cada fila corresponde a un estado de origen, y cada columna corresponde a un estado de destino. La entrada en la fila "Soleado" y columna "Nublado" (0.33) representa la probabilidad de transición del estado "soleado" al estado "nublado".

La matriz de transición tiene varias propiedades importantes:

- No negatividad: Todas las entradas de la matriz de transición son no negativas (Pij ≥ 0) ya que representan probabilidades.

- Suma de filas igual a 1: La suma de las entradas en cada fila es igual a 1. Esto se debe a que, como mencionamos antes, desde cualquier estado, el sistema debe moverse a algún estado en el siguiente paso. Matemáticamente, para cada fila i: ∑j Pij = 1.

- Matriz estocástica: Debido a estas dos propiedades, la matriz de transición se conoce como matriz estocástica o matriz de probabilidad.

La matriz de transición es una representación compacta y poderosa de las probabilidades de transición en una Cadena de Markov. Permite realizar cálculos y análisis importantes, como predecir la probabilidad de estar en un estado particular después de un cierto número de pasos, calcular la distribución estacionaria de la Cadena de Markov, y mucho más. Veremos algunos de estos cálculos en secciones posteriores.

Tipos de Cadenas de Markov

Las Cadenas de Markov pueden clasificarse en diferentes tipos según diversas características. Dos de las clasificaciones más importantes se basan en la naturaleza del tiempo (discreto o continuo) y en la dependencia de las probabilidades de transición con respecto al tiempo (homogéneas o no homogéneas).

Cadenas de Markov en tiempo discreto

En una Cadena de Markov en tiempo discreto, el tiempo avanza en pasos discretos, como instantes de tiempo igualmente espaciados (por ejemplo, cada hora, cada día, cada semana). Las transiciones entre estados solo pueden ocurrir en estos puntos de tiempo discretos. La secuencia de estados se indexa con números enteros no negativos (t = 0, 1, 2, ...).

La mayoría de los ejemplos que hemos discutido hasta ahora, como el modelo climático simplificado o el juego de mesa, son Cadenas de Markov en tiempo discreto. El algoritmo PageRank también se puede modelar como una Cadena de Markov en tiempo discreto, donde cada paso de tiempo representa un "clic" aleatorio en un enlace.

Las Cadenas de Markov en tiempo discreto son más fáciles de entender e implementar computacionalmente, y son ampliamente utilizadas en diversas aplicaciones.

Cadenas de Markov en tiempo continuo

En contraste, en una Cadena de Markov en tiempo continuo, el tiempo fluye continuamente. Las transiciones entre estados pueden ocurrir en cualquier instante de tiempo. El tiempo se representa como una variable continua, y la secuencia de estados se define para todo t ≥ 0.

Modelar fenómenos como el tiempo de espera en una cola, la desintegración radiactiva o la propagación de una enfermedad infecciosa a menudo requiere Cadenas de Markov en tiempo continuo. Por ejemplo, en un modelo de cola de espera, los estados podrían representar el número de clientes en el sistema. Las transiciones entre estados ocurren cuando llega un nuevo cliente (transición de estado n a n+1) o cuando un cliente termina su servicio y abandona el sistema (transición de estado n a n-1). Estos eventos pueden ocurrir en cualquier instante de tiempo, por lo que un modelo de tiempo continuo es más apropiado.

Las Cadenas de Markov en tiempo continuo son matemáticamente más complejas que las de tiempo discreto y requieren herramientas matemáticas diferentes para su análisis, como ecuaciones diferenciales. Sin embargo, son esenciales para modelar fenómenos que evolucionan continuamente en el tiempo.

Cadenas de Markov homogéneas

Otra clasificación importante se refiere a la dependencia de las probabilidades de transición con respecto al tiempo. Una Cadena de Markov se dice que es homogénea (o estacionaria) si las probabilidades de transición Pij son constantes a lo largo del tiempo. Esto significa que la probabilidad de pasar del estado si al estado sj es la misma en cualquier paso de tiempo.

En términos de la matriz de transición, en una Cadena de Markov homogénea, la matriz de transición P es la misma para todos los pasos de tiempo. El modelo climático simplificado que hemos estado utilizando hasta ahora es un ejemplo de Cadena de Markov homogénea, asumiendo que las probabilidades de transición entre los estados del clima no cambian con el tiempo (lo cual, por supuesto, es una simplificación de la realidad).

La homogeneidad simplifica enormemente el análisis de las Cadenas de Markov. Permite realizar cálculos a largo plazo, como encontrar la distribución estacionaria, que describiremos más adelante.

Cadenas de Markov no homogéneas

En contraste, una Cadena de Markov se dice que es no homogénea (o no estacionaria) si las probabilidades de transición Pij varían con el tiempo. En este caso, la probabilidad de transición del estado si al estado sj en el paso de tiempo t puede ser diferente de la probabilidad de transición en el paso de tiempo t+1. Formalmente, la probabilidad de transición se denota como Pij(t).

En términos de la matriz de transición, en una Cadena de Markov no homogénea, la matriz de transición P(t) depende del tiempo t. Modelar la propagación de una enfermedad infecciosa durante una epidemia podría requerir una Cadena de Markov no homogénea, ya que las probabilidades de transición (por ejemplo, la probabilidad de infectarse) pueden cambiar con el tiempo debido a factores como las medidas de control de la enfermedad o la inmunidad de la población.

Las Cadenas de Markov no homogéneas son más complejas de analizar que las homogéneas, pero son necesarias para modelar sistemas donde las probabilidades de transición cambian con el tiempo.

En la práctica, la mayoría de las introducciones a las Cadenas de Markov se centran en el caso de tiempo discreto y homogéneo, debido a su simplicidad y a que muchas aplicaciones importantes pueden modelarse de esta manera. Sin embargo, es importante ser consciente de la existencia de los otros tipos y elegir el tipo de modelo más apropiado para cada problema específico.

Componentes de un Modelo de Markov

Para definir completamente un modelo de Cadena de Markov, necesitamos especificar varios componentes clave. Estos componentes nos permiten construir el modelo y realizar análisis y predicciones.

Matriz inicial (o vector de estado inicial)

La matriz inicial, también conocida como vector de estado inicial, describe la distribución de probabilidad de los estados en el tiempo inicial (t=0). Es un vector fila (o matriz de 1xn si tenemos n estados) donde la entrada i-ésima representa la probabilidad de que el sistema se encuentre en el estado si en el tiempo inicial.

Denotemos el vector de estado inicial como π0. Entonces, la i-ésima entrada de π0, denotada como π0(i), es la probabilidad de que el sistema comience en el estado si:

π0(i) = P(X0 = si)

Al igual que las probabilidades de transición, las probabilidades en el vector de estado inicial deben ser no negativas y sumar 1:

π0(i) ≥ 0 para todo i

∑i π0(i) = 1

En algunos casos, el estado inicial del sistema se conoce con certeza. Por ejemplo, en un modelo de juego de mesa, podríamos empezar siempre en la casilla de salida. En este caso, el vector de estado inicial tendrá un 1 en la posición correspondiente al estado inicial y 0 en todas las demás posiciones. En otros casos, el estado inicial puede ser incierto, y el vector de estado inicial reflejará esta incertidumbre con una distribución de probabilidad no trivial.

Matriz de transición

Como ya hemos discutido en detalle, la matriz de transición P es un componente esencial de un modelo de Cadena de Markov. Define las probabilidades de transición entre todos los pares de estados posibles en un solo paso de tiempo. Es una matriz cuadrada de tamaño n x n (si tenemos n estados), donde la entrada (i, j) representa la probabilidad de transición Pij del estado si al estado sj:

Pij = P(Xt+1 = sj | Xt = si)

La matriz de transición es fundamental para modelar la dinámica del sistema a lo largo del tiempo. Junto con el vector de estado inicial, define completamente una Cadena de Markov homogénea en tiempo discreto.

Variables a observar y su periodicidad

En algunos modelos de Cadenas de Markov, estamos interesados directamente en la secuencia de estados. Por ejemplo, en el modelo del clima, los estados ("soleado", "nublado", "lluvioso") son las variables que observamos directamente. Sin embargo, en otros casos, podemos estar interesados en variables que son funciones de los estados, o en observaciones que están relacionadas con los estados pero no son idénticas a ellos.

Por ejemplo, en un modelo de Cadena de Markov para el reconocimiento de voz, los estados pueden representar fonemas (unidades básicas de sonido del habla), pero las variables que observamos son las ondas sonoras acústicas. En este caso, necesitamos especificar cómo se relacionan las observaciones con los estados subyacentes. Esto se hace típicamente a través de una distribución de probabilidad de observación para cada estado.

La periodicidad de las observaciones también es importante. ¿Observamos el sistema en cada paso de tiempo, o solo en intervalos de tiempo más largos? La frecuencia de las observaciones puede afectar el análisis y las inferencias que podemos hacer a partir del modelo.

Valores que pueden tomar las variables (estados posibles)

Una vez definidas las variables a observar en un modelo de Cadenas de Markov, es crucial especificar el conjunto de valores o estados que estas variables pueden tomar. Este conjunto define el espacio de estados de la cadena, que puede ser finito o infinito, discreto o continuo, aunque las implementaciones más comunes se centran en espacios de estados finitos y discretos por su tratabilidad matemática.

Cada estado debe ser:

- Mutuamente excluyente: El sistema no puede estar en dos estados simultáneamente.

- Colectivamente exhaustivo: El sistema siempre debe estar en alguno de los estados definidos.

- Claramente definido: Los criterios para determinar el estado actual del sistema deben ser inequívocos.

La granularidad con que definimos estos estados representa un compromiso importante. Con demasiados estados, el modelo puede volverse excesivamente complejo y requerir grandes cantidades de datos para estimar las probabilidades de transición. Con muy pocos estados, podríamos perder información valiosa sobre el comportamiento del sistema.

Por ejemplo, al modelar los precios de una acción, podríamos definir estados como "bajo" (menor a $10), "medio" ($10-$20) y "alto" (mayor a $20). Alternativamente, podríamos optar por una granularidad más fina con rangos de precios más estrechos. La elección dependerá del propósito específico del modelo y la disponibilidad de datos.

En algunos casos, los estados naturales del sistema son evidentes (como "soleado", "nublado" y "lluvioso" para un modelo climático). En otros, puede requerirse un análisis cuidadoso para determinar la definición más útil de los estados, posiblemente utilizando técnicas de agrupamiento o discretización de datos continuos.

Cálculo de Probabilidades y Matrices de Transición

Una vez que hemos definido los componentes de un modelo de Cadena de Markov, el siguiente paso es aprender a calcular probabilidades y trabajar con las matrices de transición. Estos cálculos son esenciales para realizar predicciones, analizar el comportamiento a largo plazo del sistema y responder a preguntas específicas sobre el modelo.

Reglas para la matriz de transición

La matriz de transición de una Cadena de Markov debe cumplir con ciertas reglas fundamentales para ser válida matemáticamente y útil en la práctica. Estas reglas aseguran que la matriz represente correctamente un proceso estocástico de Markov.

La primera y más básica regla es que todos los elementos de la matriz deben ser probabilidades válidas, lo que significa que cada elemento Pᵢⱼ debe estar en el intervalo [0, 1]. Un valor de 0 indica que es imposible la transición del estado i al estado j en un solo paso, mientras que un valor de 1 indica certeza.

La segunda regla crucial es que cada fila de la matriz debe sumar exactamente 1. Esto se debe a que, desde cualquier estado i, el sistema debe transicionar a algún estado en el siguiente paso (que puede ser el mismo estado i u otro distinto). Matemáticamente: ∑ⱼ Pᵢⱼ = 1 para todo i.

Además de estas reglas matemáticas, existen consideraciones prácticas importantes. La matriz debe ser coherente con el comportamiento real del sistema que se está modelando. Esto puede verificarse comparando las predicciones del modelo con datos históricos o con conocimiento experto sobre el sistema.

En ciertos contextos, pueden aplicarse reglas adicionales. Por ejemplo, en algunas aplicaciones como modelos de PageRank, se requiere que la matriz sea estocástica por columnas además de por filas, o que sea irreducible y aperiódica para garantizar la convergencia a una distribución estacionaria única.

Estas reglas no son meras formalidades matemáticas; son garantías de que nuestro modelo de Cadenas de Markov representará un proceso probabilístico válido y proporcionará predicciones significativas.

Matriz de un paso (M1)

La matriz de un paso, que simplemente es la matriz de transición P que hemos estado discutiendo, describe las probabilidades de transición en un solo paso de tiempo. A menudo la denotaremos como M1 para enfatizar que se refiere a un solo paso. M1 = P.

Como ya hemos visto, M1 es una matriz cuadrada de tamaño n x n donde la entrada (i, j) es la probabilidad de transición del estado si al estado sj en un solo paso. M1 es la base para calcular probabilidades de transición en múltiples pasos.

Matrices de n pasos: Cómo calcularlas

Para predecir el estado del sistema después de n pasos de tiempo, necesitamos calcular las probabilidades de transición en n pasos. La matriz de transición en n pasos, denotada como Pn o Mn, describe las probabilidades de transición del estado si al estado sj en exactamente n pasos de tiempo. La entrada (i, j) de la matriz Pn, denotada como Pnij, es la probabilidad de pasar del estado si al estado sj en n pasos:

Pnij = P(Xt+n = sj | Xt = si)

Existen dos formas principales de calcular las matrices de n pasos:

Multiplicación de matrices

Una propiedad fundamental de las Cadenas de Markov es que la matriz de transición en n pasos se puede obtener multiplicando la matriz de un paso P por sí misma n veces. En otras palabras,

Pn = P * P * ... * P (n veces) = Pn

Esta propiedad se deriva de la propiedad de Markov y de la ley de probabilidad total. Para ir del estado si al estado sj en n pasos, el sistema debe pasar por algún estado intermedio en cada paso. La multiplicación de matrices combina todas las posibles secuencias de transiciones de un paso para obtener las probabilidades de transición en n pasos.

Por ejemplo, para calcular la matriz de transición en 2 pasos (P2), simplemente multiplicamos la matriz de un paso P por sí misma: P2 = P * P. Para calcular la matriz de transición en 3 pasos (P3), multiplicamos P2 por P: P3 = P2 * P = P * P * P, y así sucesivamente.

Ejemplo de Multiplicación de Matrices:

Consideremos una Cadena de Markov con dos estados (S1, S2) y la siguiente matriz de transición de un paso:

S1 S2

S1 0.7 0.3

S2 0.4 0.6

Para calcular la matriz de transición de 2 pasos (M2), multiplicamos M1 por sí misma:

M2 = M1 * M1 =

[0.7 0.3] * [0.7 0.3] = [ (0.7*0.7 + 0.3*0.4) (0.7*0.3 + 0.3*0.6) ] = [0.61 0.39]

[0.4 0.6] [0.4 0.6] [ (0.4*0.7 + 0.6*0.4) (0.4*0.3 + 0.6*0.6) ] [0.52 0.48]

Por lo tanto, la matriz de transición de 2 pasos es:

S1 S2

S1 0.61 0.39

S2 0.52 0.48

La entrada (1, 1) = 0.61 representa la probabilidad de pasar del estado S1 al estado S1 en exactamente 2 pasos.

Potenciación de la matriz M1

Como hemos visto, calcular la matriz de transición en n pasos implica multiplicar la matriz de un paso P por sí misma n veces. Esto es equivalente a elevar la matriz P a la potencia n: Pn.

Pn = Pn

La potenciación de matrices puede realizarse de manera eficiente utilizando algoritmos como la exponenciación binaria, que reduce el número de multiplicaciones de matrices necesarias. Las bibliotecas de álgebra lineal en lenguajes de programación como Python (por ejemplo, NumPy) proporcionan funciones eficientes para la multiplicación y potenciación de matrices.

Las Cadenas de Markov tienen una amplia gama de aplicaciones en diversos campos. Una de las más interesantes y prácticas es la predicción a corto plazo. Si te gustaría profundizar en cómo utilizar las Cadenas de Markov para anticipar eventos inmediatos y tomar decisiones informadas, te recomendamos leer nuestro artículo detallado sobre Predicción a Corto Plazo con Cadenas de Markov: Una Guía Paso a Paso. Allí encontrarás una guía práctica y ejemplos para aplicar este tipo de predicción.

Análisis a Largo Plazo de las Cadenas de Markov

Una de las preguntas más interesantes sobre las Cadenas de Markov es su comportamiento a largo plazo. ¿A qué estado o distribución de estados tiende el sistema a medida que el tiempo tiende a infinito? El análisis a largo plazo de las Cadenas de Markov se centra en conceptos como la matriz de estado estable, los estados absorbentes y los estados transitorios, que nos permiten responder a estas preguntas.

Matriz de estado estable: qué es y cómo se interpreta

Para algunas Cadenas de Markov, a medida que el número de pasos n tiende a infinito, la matriz de transición en n pasos Pn converge a una matriz límite, conocida como matriz de estado estable o matriz estacionaria, denotada como Π.

Π = limn→∞ Pn

En la matriz de estado estable Π, todas las filas son idénticas y representan la distribución de probabilidad estacionaria o distribución límite de la Cadena de Markov. Denotemos esta distribución estacionaria como π. Entonces, cada fila de Π es igual a πT (la transpuesta de π, un vector columna).

La distribución estacionaria π es un vector fila donde la i-ésima entrada π(i) representa la probabilidad de que el sistema se encuentre en el estado si en el estado estacionario, es decir, después de un tiempo suficientemente largo. En el estado estacionario, la distribución de probabilidad de los estados ya no cambia con el tiempo. En otras palabras, si el sistema está en el estado estacionario en el tiempo t, también estará en el estado estacionario en el tiempo t+1, en términos probabilísticos.

La distribución estacionaria π satisface la siguiente ecuación matricial:

π = π * P

Y también la condición de normalización:

∑i π(i) = 1

La ecuación π = π * P dice que la distribución estacionaria es un vector propio izquierdo de la matriz de transición P con valor propio 1. En muchas Cadenas de Markov importantes (especialmente las irreducibles y aperiódicas), existe una única distribución estacionaria.

Interpretación de la matriz de estado estable:

La matriz de estado estable Π (o equivalentemente, la distribución estacionaria π) nos proporciona información valiosa sobre el comportamiento a largo plazo de la Cadena de Markov. La entrada (i, j) de Π, que es igual a π(j), representa la probabilidad a largo plazo de estar en el estado sj, independientemente del estado inicial si. En otras palabras, la distribución estacionaria nos dice a qué estados tiende a "asentarse" el sistema a medida que el tiempo avanza.

Cálculo de la matriz de estado estable:

Existen diferentes métodos para calcular la matriz de estado estable o la distribución estacionaria. Uno de los métodos es calcular potencias sucesivas de la matriz de transición Pn para valores grandes de n hasta que converjan a una matriz límite. Otro método es resolver el sistema de ecuaciones lineales π = π * P junto con la condición de normalización ∑i π(i) = 1.

Ejemplo de cálculo de la distribución estacionaria:

Volviendo al ejemplo de la Cadena de Markov con dos estados y la matriz de transición:

S1 S2

S1 0.7 0.3

S2 0.4 0.6

Para encontrar la distribución estacionaria π = [π(S1) π(S2)], necesitamos resolver el sistema de ecuaciones:

π(S1) = 0.7 * π(S1) + 0.4 * π(S2)

π(S2) = 0.3 * π(S1) + 0.6 * π(S2)

π(S1) + π(S2) = 1

Resolviendo este sistema de ecuaciones, obtenemos:

π(S1) = 4/7 ≈ 0.57

π(S2) = 3/7 ≈ 0.43

Por lo tanto, la distribución estacionaria es aproximadamente π = [0.57 0.43]. Esto significa que, a largo plazo, el sistema pasará aproximadamente el 57% del tiempo en el estado S1 y el 43% del tiempo en el estado S2, independientemente del estado inicial.

Estado absorbente (o estacionario)

Un estado absorbente, también conocido como estado estacionario (en un sentido diferente al de la distribución estacionaria), es un estado del que el sistema nunca puede salir una vez que entra en él. Formalmente, un estado si es absorbente si la probabilidad de permanecer en ese estado es 1, es decir, Pii = 1. Esto implica que la probabilidad de transición a cualquier otro estado desde un estado absorbente es 0.

En términos de la matriz de transición, una fila correspondiente a un estado absorbente tendrá un 1 en la diagonal y 0 en todas las demás posiciones.

Ejemplos de estados absorbentes:

- En un modelo de "ratón en un laberinto", un estado absorbente podría representar la llegada del ratón a la salida del laberinto. Una vez que el ratón llega a la salida, el proceso termina.

- En un modelo de enfermedad, un estado absorbente podría representar la muerte del paciente. Una vez que el paciente fallece, no puede volver a estar enfermo.

- En un modelo de juego, un estado absorbente podría representar la victoria o la derrota. Una vez que el juego termina, el estado no cambia más.

La presencia de estados absorbentes afecta significativamente el comportamiento a largo plazo de una Cadena de Markov. Si una Cadena de Markov tiene uno o más estados absorbentes, y es posible alcanzar un estado absorbente desde cualquier estado inicial (con probabilidad positiva), entonces, a largo plazo, el sistema será absorbido por uno de los estados absorbentes con probabilidad 1. En este caso, no existe una distribución estacionaria en el sentido discutido en la sección anterior (a menos que todos los estados sean absorbentes).

El análisis de Cadenas de Markov con estados absorbentes se centra en calcular probabilidades de absorción (la probabilidad de ser absorbido por un estado absorbente particular, dado un estado inicial) y tiempos medios de absorción (el número esperado de pasos hasta que se alcanza un estado absorbente, dado un estado inicial).

Estados transitorios

Un estado transitorio es un estado que el sistema puede abandonar y nunca regresar a él con probabilidad positiva. Formalmente, un estado si es transitorio si existe una probabilidad no nula de que, comenzando en si, el sistema nunca regrese a si en el futuro.

En contraste, un estado recurrente es un estado que el sistema regresará a con probabilidad 1 si lo abandona. Todo estado que no es transitorio y no es absorbente es recurrente.

Ejemplos de estados transitorios:

- En un modelo de "ratón en un laberinto", los estados que representan las casillas del laberinto que no son la salida pueden ser estados transitorios. El ratón puede pasar por estas casillas, pero eventualmente puede llegar a la salida y nunca regresar a ellas.

- En un modelo de juego, los estados intermedios del juego que no son ni la victoria ni la derrota pueden ser estados transitorios. El juego progresa a través de estos estados, pero finalmente terminará en un estado absorbente (victoria o derrota).

En una Cadena de Markov con estados absorbentes, todos los estados no absorbentes son transitorios. El sistema eventualmente será absorbido por un estado absorbente, y nunca regresará a los estados transitorios.

En el análisis a largo plazo de Cadenas de Markov con estados transitorios, nos interesa calcular probabilidades de visita a los estados transitorios y el número esperado de visitas a cada estado transitorio antes de la absorción (si existen estados absorbentes) o antes de que el sistema se mueva a un comportamiento a largo plazo diferente.

Aplicaciones Prácticas de las Cadenas de Markov

Como hemos mencionado anteriormente, las Cadenas de Markov tienen una amplia gama de aplicaciones en diversos campos. Vamos a explorar algunas de las aplicaciones prácticas más relevantes y sorprendentes de las Cadenas de Markov.

Google PageRank

Ya hemos mencionado Google PageRank como una de las aplicaciones más famosas y exitosas de las Cadenas de Markov. El algoritmo PageRank, desarrollado por Larry Page y Sergey Brin, fundadores de Google, utiliza una Cadena de Markov para determinar la importancia de las páginas web y ordenarlas en los resultados de búsqueda.

El modelo de PageRank se basa en la idea de un "navegador aleatorio" que navega por la web haciendo clic aleatoriamente en los enlaces. Cada página web se considera un estado en la Cadena de Markov. La probabilidad de transición de una página web i a una página web j se define como:

- Si la página i tiene enlaces a k páginas, y una de ellas es la página j, entonces la probabilidad de transición de i a j es 1/k.

- Si la página i no tiene enlaces a ninguna página (un "sumidero"), entonces se asume que el navegador aleatorio salta aleatoriamente a cualquier página de la web con probabilidad uniforme.

- Se introduce un factor de "teletransportación" (típicamente alrededor del 15%) para simular la posibilidad de que el navegador aleatorio salte a una página aleatoria incluso si hay enlaces disponibles en la página actual. Esto asegura que el modelo sea irreducible y tenga una distribución estacionaria única.

La distribución estacionaria de esta Cadena de Markov define el PageRank de cada página web. Las páginas web con un PageRank más alto son consideradas más importantes y se muestran en los primeros resultados de búsqueda. El PageRank fue un factor clave en el éxito inicial de Google y sigue siendo un componente importante de su algoritmo de búsqueda.

Reconocimiento de voz

Las Cadenas de Markov se utilizan ampliamente en sistemas de reconocimiento de voz (ASR) para modelar las secuencias de fonemas en el habla. Un sistema ASR tiene como objetivo transcribir el habla humana en texto. El proceso de habla puede modelarse como una secuencia de estados, donde cada estado representa un fonema (por ejemplo, el sonido "a", "b", "c", etc.). Las transiciones entre fonemas se rigen por probabilidades de transición, que pueden estimarse a partir de grandes corpus de habla anotada.

En los modelos de reconocimiento de voz basados en Cadenas de Markov, se combinan dos tipos de modelos probabilísticos:

- Modelos acústicos: Modelan la probabilidad de observar ciertas características acústicas (por ejemplo, frecuencias, energía) dado un fonema particular. A menudo se utilizan Modelos Ocultos de Markov (HMMs), que son una extensión de las Cadenas de Markov donde los estados son "ocultos" (no directamente observados) y solo se observan las emisiones probabilísticas asociadas a cada estado (las características acústicas).

- Modelos de lenguaje: Modelan la probabilidad de secuencias de palabras en un idioma. Las Cadenas de Markov (en particular, los modelos de n-gramas) se utilizan para estimar la probabilidad de que una palabra siga a una secuencia de palabras anteriores. Por ejemplo, un modelo de lenguaje podría asignar una probabilidad más alta a la secuencia "el gato está sentado" que a la secuencia "gato el está sentado".

Al combinar modelos acústicos y modelos de lenguaje basados en Cadenas de Markov, los sistemas ASR pueden transcribir el habla humana en texto con una precisión razonable. Las Cadenas de Markov siguen siendo un componente fundamental en muchos sistemas ASR modernos, aunque se están utilizando cada vez más enfoques basados en redes neuronales profundas, que también pueden considerarse extensiones y generalizaciones de las Cadenas de Markov.

Finanzas y trading

Las Cadenas de Markov se han aplicado en finanzas y trading para modelar el comportamiento de los precios de activos financieros, aunque con limitaciones. En modelos simples, se puede asumir que el precio de un activo (por ejemplo, una acción) puede encontrarse en uno de varios estados discretos (por ejemplo, "subiendo", "bajando", "estable"). Las transiciones entre estos estados pueden modelarse mediante una Cadena de Markov, donde las probabilidades de transición se estiman a partir de datos históricos de precios.

Estos modelos pueden utilizarse para realizar predicciones sobre la evolución futura de los precios y para tomar decisiones de trading. Por ejemplo, si la Cadena de Markov predice una alta probabilidad de transición al estado "subiendo" en el próximo paso, un trader podría decidir comprar el activo.

Sin embargo, es importante tener en cuenta que los mercados financieros son sistemas muy complejos y a menudo impredecibles. La hipótesis de Markov (memoria limitada) puede no ser completamente válida para los precios de los activos financieros, que pueden verse influenciados por una amplia gama de factores, incluyendo noticias económicas, eventos políticos, sentimiento del mercado, etc. Por lo tanto, los modelos de Cadenas de Markov en finanzas deben utilizarse con cautela y complementarse con otros enfoques más sofisticados.

Bioinformática

En bioinformática, las Cadenas de Markov se utilizan en el análisis de secuencias de ADN y proteínas. Las secuencias de ADN y proteínas pueden considerarse como cadenas de caracteres (nucleótidos o aminoácidos, respectivamente). Los modelos de Cadenas de Markov pueden utilizarse para modelar la probabilidad de diferentes secuencias y para identificar patrones y características importantes en estas secuencias.

Aplicaciones específicas en bioinformática:

- Alineamiento de secuencias: Las Cadenas de Markov se utilizan en algoritmos de alineamiento de secuencias para determinar el grado de similitud entre dos o más secuencias biológicas. Los modelos de Markov pueden modelar la probabilidad de inserciones, eliminaciones y sustituciones de caracteres a lo largo del tiempo evolutivo, permitiendo alinear secuencias de manera óptima.

- Búsqueda de genes: Los modelos de Cadenas de Markov pueden utilizarse para identificar regiones codificantes de genes en secuencias de ADN. Las regiones codificantes (exones) suelen tener patrones estadísticos diferentes de las regiones no codificantes (intrones). Los modelos de Markov pueden entrenarse para distinguir entre estos patrones y predecir la ubicación de los genes.

- Predicción de estructura de proteínas: Las Cadenas de Markov se han utilizado en métodos para predecir la estructura tridimensional de las proteínas a partir de su secuencia de aminoácidos. Los modelos de Markov pueden modelar las probabilidades de diferentes configuraciones estructurales locales (por ejemplo, hélices alfa, láminas beta) y combinarlas para predecir la estructura global.

- Análisis filogenético: Los modelos de Cadenas de Markov se utilizan para modelar la evolución de las secuencias de ADN y proteínas a lo largo del tiempo evolutivo. Estos modelos pueden utilizarse para construir árboles filogenéticos que representen las relaciones evolutivas entre diferentes especies o genes.

Las Cadenas de Markov proporcionan un marco probabilístico poderoso y versátil para el análisis de datos de secuencias biológicas, y siguen siendo una herramienta importante en bioinformática.

Sistemas de recomendación (ej. Spotify)

Los sistemas de recomendación, como los utilizados por Spotify, Netflix, Amazon y YouTube, utilizan Cadenas de Markov (y modelos más complejos basados en ellas) para predecir las preferencias de los usuarios y recomendar contenido relevante. En un sistema de recomendación basado en Cadenas de Markov, el historial de interacciones de un usuario (por ejemplo, canciones escuchadas, películas vistas, productos comprados) se modela como una secuencia de estados. Cada estado representa un ítem (canción, película, producto) o una categoría de ítems.

Las probabilidades de transición entre estados se estiman a partir de los datos de interacción de los usuarios. Por ejemplo, si muchos usuarios que escucharon la canción A también escucharon la canción B después, entonces la probabilidad de transición de la canción A a la canción B será alta.

Una vez que se ha entrenado el modelo de Cadena de Markov, se puede utilizar para hacer recomendaciones a un usuario. Dado el historial de interacciones del usuario hasta el momento actual (es decir, la secuencia de estados visitados hasta ahora), el sistema puede predecir el estado más probable en el siguiente paso y recomendar el ítem correspondiente. Por ejemplo, si un usuario ha estado escuchando canciones de jazz recientemente, el sistema podría recomendar la canción de jazz con la probabilidad de transición más alta desde la última canción escuchada.

Los sistemas de recomendación basados en Cadenas de Markov pueden personalizarse para cada usuario individual, utilizando su historial de interacciones personal para estimar las probabilidades de transición. Sin embargo, estos modelos también pueden tener limitaciones, como la incapacidad de capturar dependencias a largo plazo en las preferencias de los usuarios o de manejar el problema del "inicio en frío" (recomendaciones para nuevos usuarios con poco o ningún historial de interacciones). Los sistemas de recomendación modernos suelen combinar Cadenas de Markov con otros enfoques, como el filtrado colaborativo y el aprendizaje profundo, para mejorar la precisión y la diversidad de las recomendaciones.

Predicción del tiempo

Aunque los modelos meteorológicos modernos son mucho más sofisticados y complejos, las Cadenas de Markov pueden utilizarse para construir modelos simplificados de predicción del tiempo. Como hemos visto en ejemplos anteriores, podemos modelar el clima en un lugar dado utilizando un número pequeño de estados discretos (por ejemplo, "soleado", "nublado", "lluvioso"). Las probabilidades de transición entre estos estados pueden estimarse a partir de datos históricos del clima.

Una vez que tenemos la matriz de transición, podemos utilizarla para predecir el clima en el futuro. Dado el clima actual, podemos calcular la distribución de probabilidad del clima para el día siguiente, para el día después, y así sucesivamente, utilizando la multiplicación de matrices de transición.

Por ejemplo, si hoy está "soleado", podemos multiplicar el vector de estado actual (que sería [1, 0, 0] si estamos seguros de que está soleado) por la matriz de transición para obtener la distribución de probabilidad del clima para mañana. Repitiendo este proceso, podemos obtener predicciones para días más lejanos en el futuro.

Los modelos de predicción del tiempo basados en Cadenas de Markov son, por supuesto, muy simplificados y no capturan la complejidad de la atmósfera terrestre. Los modelos meteorológicos profesionales utilizan ecuaciones hidrodinámicas y termodinámicas complejas, resueltas numéricamente en supercomputadoras, y combinan datos de satélites, radares y estaciones meteorológicas terrestres. Sin embargo, los modelos de Cadenas de Markov pueden proporcionar una introducción intuitiva a la modelización probabilística del tiempo y pueden ser útiles para predicciones a muy corto plazo o para sistemas climáticos muy simplificados.

Análisis del comportamiento del consumidor

Las Cadenas de Markov se aplican en marketing y análisis del comportamiento del consumidor para modelar los patrones de compra y las preferencias de los clientes. En estos modelos, los estados pueden representar diferentes productos, categorías de productos o marcas. Las transiciones entre estados representan las transiciones entre compras o selecciones de productos.

Por ejemplo, en un modelo de Cadena de Markov para el comportamiento de compra de café, los estados podrían ser diferentes marcas de café (por ejemplo, "Marca A", "Marca B", "Marca C", "Ninguna compra"). Las probabilidades de transición pueden estimarse a partir de datos de compras históricas de los clientes. Por ejemplo, si un cliente compró la "Marca A" en su última compra, la probabilidad de que compre la "Marca B" en su próxima compra sería la probabilidad de transición de "Marca A" a "Marca B".

Estos modelos pueden utilizarse para:

- Predecir la probabilidad de compra de diferentes productos en el futuro.

- Segmentar a los clientes en función de sus patrones de compra.

- Evaluar la efectividad de las campañas de marketing y promociones.

- Optimizar la colocación de productos en las tiendas y en los sitios web.

- Desarrollar sistemas de recomendación de productos personalizados.

El análisis del comportamiento del consumidor basado en Cadenas de Markov puede proporcionar información valiosa para las empresas y ayudarles a tomar decisiones más informadas sobre marketing, ventas y desarrollo de productos.

Procesamiento del lenguaje natural

Además del reconocimiento de voz, las Cadenas de Markov se utilizan en muchas otras áreas del procesamiento del lenguaje natural (PNL). Ya hemos mencionado los modelos de lenguaje basados en n-gramas, que son un tipo de Cadena de Markov utilizado para modelar la probabilidad de secuencias de palabras. Estos modelos son fundamentales para tareas como la corrección ortográfica, la traducción automática y la generación de texto.

Otras aplicaciones de las Cadenas de Markov en PNL:

- Etiquetado gramatical (Part-of-Speech Tagging): Asignar etiquetas gramaticales (por ejemplo, sustantivo, verbo, adjetivo) a cada palabra en una oración. Los Modelos Ocultos de Markov (HMMs) se utilizan ampliamente para esta tarea.

- Reconocimiento de entidades nombradas (Named Entity Recognition): Identificar y clasificar entidades nombradas (por ejemplo, personas, organizaciones, lugares) en texto. Los HMMs y otras extensiones de las Cadenas de Markov se han utilizado para NER.

- Análisis de sentimiento: Determinar la polaridad emocional (positiva, negativa, neutral) de un texto. Las Cadenas de Markov pueden utilizarse para modelar las transiciones entre diferentes estados emocionales en un texto.

- Generación de texto: Generar texto similar al humano. Los modelos de lenguaje basados en Cadenas de Markov pueden utilizarse para generar texto palabra por palabra, prediciendo la siguiente palabra más probable dada la secuencia de palabras anteriores.

Las Cadenas de Markov proporcionan un marco probabilístico útil para modelar secuencias en el lenguaje natural y siguen siendo una herramienta relevante en muchas tareas de PNL.

Redes sociales

El análisis de redes sociales es otro campo donde las Cadenas de Markov encuentran aplicaciones. Las redes sociales pueden modelarse como grafos donde los nodos representan personas o entidades y los enlaces representan relaciones entre ellos (por ejemplo, amistad, seguimiento, interacción). Las Cadenas de Markov pueden utilizarse para modelar la propagación de información, ideas o comportamiento en redes sociales.

Aplicaciones en redes sociales:

- Modelado de la propagación de información: Modelar cómo se difunde una noticia, un rumor o una tendencia en una red social. Los estados pueden representar si un individuo ha recibido o no la información, y las transiciones pueden modelar la probabilidad de que un individuo comparta la información con sus contactos.

- Análisis de la influencia social: Identificar a los individuos más influyentes en una red social. Se pueden utilizar medidas basadas en Cadenas de Markov, como el PageRank, para evaluar la influencia de los nodos en la red.

- Detección de comunidades: Identificar grupos de individuos estrechamente conectados en una red social. Las Cadenas de Markov aleatorias (random walks) en grafos pueden utilizarse para detectar comunidades basadas en la densidad de las conexiones internas.

- Sistemas de recomendación social: Recomendar amigos o conexiones a los usuarios en redes sociales. Las Cadenas de Markov pueden modelar los patrones de interacción entre usuarios y recomendar conexiones basadas en la similitud de sus patrones de interacción.

Las Cadenas de Markov proporcionan herramientas valiosas para entender la dinámica y la estructura de las redes sociales.

Inventario y logística

En gestión de inventario y logística, las Cadenas de Markov se utilizan para modelar la demanda de productos, la gestión de inventarios y la optimización de rutas de transporte.

Aplicaciones en inventario y logística:

- Predicción de la demanda: Modelar la demanda de productos como una Cadena de Markov, donde los estados representan diferentes niveles de demanda (por ejemplo, baja, media, alta). Las probabilidades de transición pueden estimarse a partir de datos históricos de ventas. Estos modelos pueden utilizarse para predecir la demanda futura y planificar los niveles de inventario adecuados.

- Optimización de políticas de inventario: Determinar las políticas de inventario óptimas (por ejemplo, niveles de reorden, cantidades de pedido) para minimizar los costos de inventario (costos de almacenamiento, costos de escasez, costos de pedido). Se pueden utilizar modelos de Cadenas de Markov para evaluar el rendimiento de diferentes políticas de inventario bajo diferentes escenarios de demanda.

- Optimización de rutas de transporte: En problemas de enrutamiento de vehículos y logística de distribución, las Cadenas de Markov pueden utilizarse para modelar la probabilidad de diferentes rutas y para encontrar rutas óptimas que minimicen los costos de transporte o el tiempo de entrega.

- Mantenimiento predictivo: Modelar el estado de los equipos y maquinaria como una Cadena de Markov, donde los estados representan diferentes niveles de desgaste o funcionamiento (por ejemplo, "en buen estado", "desgaste leve", "desgaste grave", "fallo"). Las probabilidades de transición pueden estimarse a partir de datos históricos de mantenimiento y fallos. Estos modelos pueden utilizarse para predecir cuándo es probable que un equipo falle y planificar el mantenimiento preventivo de manera óptima.

Las Cadenas de Markov ofrecen un enfoque cuantitativo para la toma de decisiones en la gestión de inventario y logística, ayudando a las empresas a optimizar sus operaciones y reducir costos.

Control de calidad

En la industria manufacturera, las Cadenas de Markov se utilizan en control de calidad para modelar la probabilidad de que un producto pase o falle diferentes pruebas de calidad en cada etapa del proceso de producción. Cada etapa del proceso de producción puede considerarse un estado, y las transiciones entre estados representan el paso de un producto a través de las diferentes etapas y pruebas de calidad.

Aplicaciones en control de calidad:

- Modelado de procesos de producción: Modelar el flujo de productos a través de las diferentes etapas de producción como una Cadena de Markov. Los estados pueden representar las diferentes etapas del proceso, y las probabilidades de transición pueden representar la probabilidad de que un producto pase a la siguiente etapa o sea rechazado en una prueba de calidad.

- Detección de defectos: Utilizar modelos de Cadenas de Markov para detectar patrones inusuales en los datos de control de calidad que puedan indicar la presencia de defectos en el proceso de producción.

- Optimización de los procesos de inspección: Determinar las estrategias de inspección óptimas para minimizar los costos de control de calidad y maximizar la probabilidad de detectar productos defectuosos. Se pueden utilizar modelos de Cadenas de Markov para evaluar la efectividad de diferentes estrategias de inspección.

- Mantenimiento de la calidad del producto a lo largo del tiempo: Modelar la degradación de la calidad del producto a lo largo del tiempo como una Cadena de Markov. Esto puede ser útil para predecir la vida útil de los productos y planificar estrategias de reemplazo o mejora de la calidad.

Las Cadenas de Markov proporcionan un marco probabilístico para el control de calidad en la fabricación, ayudando a las empresas a mejorar la calidad de sus productos y reducir los costos asociados a los defectos.

Herramientas y Bibliotecas de Software para Cadenas de Markov

Existen numerosas herramientas y bibliotecas de software que facilitan el trabajo con Cadenas de Markov, especialmente en lenguajes de programación populares como Python. Estas herramientas proporcionan funciones y clases para definir, manipular, simular y analizar Cadenas de Markov, ahorrando tiempo y esfuerzo en la implementación manual de los algoritmos.

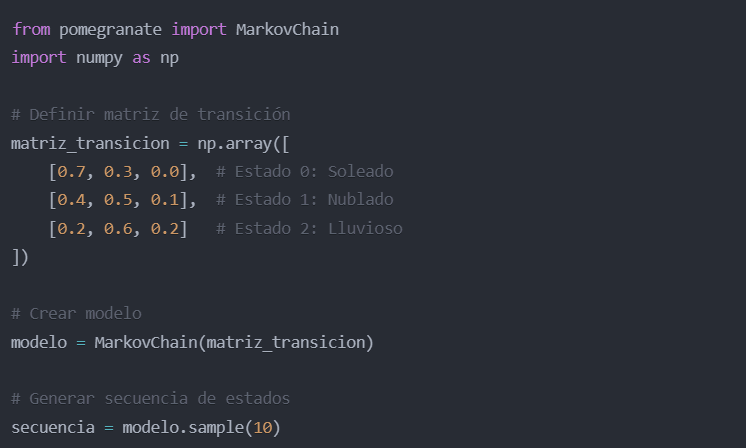

Bibliotecas de Python

Python es un lenguaje de programación muy popular en ciencia de datos, aprendizaje automático y modelado probabilístico, y cuenta con varias bibliotecas excelentes para trabajar con Cadenas de Markov:

- pomegranate: Es una biblioteca de Python especializada en modelos probabilísticos, incluyendo Cadenas de Markov, Modelos Ocultos de Markov (HMMs), Redes Bayesianas y Modelos Gráficos. pomegranate proporciona clases y funciones para definir Cadenas de Markov, estimar probabilidades de transición, calcular distribuciones estacionarias, realizar inferencia y simulación. Es una biblioteca completa y eficiente, bien documentada y ampliamente utilizada en investigación y aplicaciones prácticas.

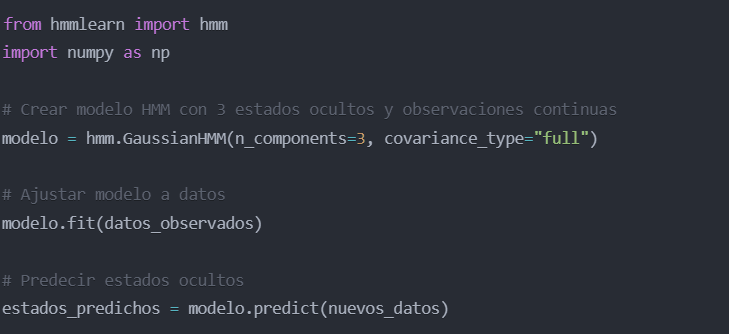

- hmmlearn: Es otra biblioteca de Python centrada en Modelos Ocultos de Markov (HMMs), pero también incluye clases para trabajar con Cadenas de Markov básicas. hmmlearn proporciona funciones para entrenar HMMs y Cadenas de Markov a partir de datos, realizar inferencia y simulación. Está construida sobre scikit-learn, una biblioteca de aprendizaje automático muy popular en Python, y se integra bien con otras herramientas del ecosistema de Python para ciencia de datos.

- Markovito: Es una biblioteca de Python más ligera y sencilla, diseñada específicamente para trabajar con Cadenas de Markov en tiempo discreto. Markovito proporciona clases para definir matrices de transición, simular trayectorias de Cadenas de Markov, calcular distribuciones estacionarias y realizar otros análisis básicos. Es una buena opción para principiantes y para aplicaciones donde se requieren funcionalidades básicas de Cadenas de Markov sin la complejidad de bibliotecas más completas como pomegranate.

- NumPy y SciPy: Aunque no son bibliotecas específicas para Cadenas de Markov, NumPy y SciPy son bibliotecas fundamentales para la computación numérica en Python y proporcionan funciones esenciales para trabajar con matrices, álgebra lineal y probabilidad. NumPy proporciona arrays multidimensionales y funciones para operaciones matriciales eficientes, mientras que SciPy incluye algoritmos para álgebra lineal, optimización y estadística. Estas bibliotecas son utilizadas internamente por las bibliotecas especializadas en Cadenas de Markov y son útiles para implementar algoritmos de Cadenas de Markov desde cero o para realizar cálculos personalizados.

Además de estas bibliotecas de Python, existen herramientas y bibliotecas para Cadenas de Markov en otros lenguajes de programación, como R, MATLAB, Java y C++, dependiendo de las necesidades y preferencias del usuario. La elección de la herramienta o biblioteca adecuada dependerá de factores como el lenguaje de programación preferido, la complejidad del modelo, la eficiencia requerida y las funcionalidades específicas necesarias.

Ejemplos Resueltos de Cadenas de Markov

Para consolidar la comprensión de los conceptos de Cadenas de Markov, es útil revisar algunos ejemplos resueltos que ilustren cómo se construyen, analizan y aplican estos modelos.

Ejemplo de asignaturas a estudiar

Imaginemos un estudiante universitario que tiene que elegir qué asignatura estudiar cada noche entre tres opciones: Matemáticas (M), Historia (H) y Literatura (L). Supongamos que la elección del estudiante sigue un patrón probabilístico que puede modelarse con una Cadena de Markov. Basándonos en su historial de estudio, estimamos las siguientes probabilidades de transición:

- Si estudia Matemáticas un día, al día siguiente estudiará Matemáticas con probabilidad 0.4, Historia con probabilidad 0.3 y Literatura con probabilidad 0.3.

- Si estudia Historia un día, al día siguiente estudiará Matemáticas con probabilidad 0.2, Historia con probabilidad 0.5 y Literatura con probabilidad 0.3.

- Si estudia Literatura un día, al día siguiente estudiará Matemáticas con probabilidad 0.3, Historia con probabilidad 0.4 y Literatura con probabilidad 0.3.

1. Matriz de transición:

La matriz de transición P para esta Cadena de Markov es:

M H L

M 0.4 0.3 0.3

H 0.2 0.5 0.3

L 0.3 0.4 0.3

Los estados son "Matemáticas" (M), "Historia" (H) y "Literatura" (L).

2. Probabilidad de estudiar Literatura después de dos noches:

Si el estudiante estudia Matemáticas la noche del lunes, ¿cuál es la probabilidad de que estudie Literatura la noche del miércoles (es decir, después de dos noches)?

Para responder a esta pregunta, necesitamos calcular la matriz de transición en 2 pasos, P2:

P^2 = P * P =

[0.4 0.3 0.3] * [0.4 0.3 0.3] = [ (0.4*0.4+0.3*0.2+0.3*0.3) (0.4*0.3+0.3*0.5+0.3*0.4) (0.4*0.3+0.3*0.3+0.3*0.3) ]

[0.2 0.5 0.3] [0.2 0.5 0.3] [ (0.2*0.4+0.5*0.2+0.3*0.3) (0.2*0.3+0.5*0.5+0.3*0.4) (0.2*0.3+0.5*0.3+0.3*0.3) ]

[0.3 0.4 0.3] [0.3 0.4 0.3] [ (0.3*0.4+0.4*0.2+0.3*0.3) (0.3*0.3+0.4*0.5+0.3*0.4) (0.3*0.3+0.4*0.3+0.3*0.3) ]

P^2 ≈

[0.31 0.33 0.36]

[0.21 0.41 0.38]

[0.29 0.39 0.32]

La entrada (1, 3) de P2 (primera fila, tercera columna) es la probabilidad de pasar del estado inicial "Matemáticas" (estado 1) al estado "Literatura" (estado 3) en 2 pasos. Esta probabilidad es aproximadamente 0.36.

Por lo tanto, si el estudiante estudia Matemáticas el lunes, la probabilidad de que estudie Literatura el miércoles es aproximadamente del 36%.

3. Distribución estacionaria:

¿Cuál es la distribución estacionaria de esta Cadena de Markov? Es decir, ¿a largo plazo, qué proporción del tiempo dedicará el estudiante a estudiar cada asignatura?

Para encontrar la distribución estacionaria π = [π(M) π(H) π(L)], resolvemos el sistema de ecuaciones π = π * P y ∑i π(i) = 1. Resolviendo este sistema (por ejemplo, utilizando métodos numéricos o algebraicos), obtenemos aproximadamente:

π(M) ≈ 0.27

π(H) ≈ 0.4

π(L) ≈ 0.33

Esto significa que, a largo plazo, el estudiante dedicará aproximadamente el 27% de las noches a estudiar Matemáticas, el 40% a Historia y el 33% a Literatura.

Otros ejemplos para ilustrar los conceptos

Además del ejemplo de las asignaturas a estudiar, podemos considerar otros ejemplos para ilustrar diferentes conceptos de Cadenas de Markov:

- Modelo de tiempo: Un modelo meteorológico simplificado con estados "soleado", "nublado" y "lluvioso", como hemos discutido anteriormente. Podemos calcular probabilidades de transición, predicciones meteorológicas a corto plazo y la distribución de probabilidad del clima a largo plazo.

- Modelo de colas: Un modelo de cola de espera en un centro de atención al cliente, con estados representando el número de clientes en la cola. Podemos calcular probabilidades de transición (llegada de nuevos clientes, finalización del servicio), tiempo medio de espera en la cola y la distribución de probabilidad del número de clientes en la cola en estado estacionario.

- Modelo de paseo aleatorio (random walk): Un modelo de movimiento aleatorio en una cuadrícula o grafo, donde los estados representan posiciones en la cuadrícula o nodos del grafo, y las transiciones representan movimientos aleatorios a estados vecinos. Los paseos aleatorios se utilizan en algoritmos como PageRank y en modelado de fenómenos de difusión y exploración.

- Modelo de juego: Un modelo de un juego de mesa o un juego de azar, donde los estados representan posiciones en el juego o resultados intermedios. Podemos calcular probabilidades de ganar, probabilidades de alcanzar ciertos estados y el tiempo medio hasta el final del juego.

Estos ejemplos ilustran la versatilidad de las Cadenas de Markov para modelar una amplia variedad de sistemas probabilísticos y para responder preguntas relevantes sobre su comportamiento.

Conclusión

Las Cadenas de Markov son una herramienta matemática poderosa y versátil para modelar sistemas que evolucionan a través del tiempo de manera probabilística. Su propiedad fundamental de "memoria limitada" o propiedad de Markov, que establece que el futuro depende solo del presente, permite simplificar el modelado de sistemas complejos y realizar predicciones y análisis significativos.

En esta guía, hemos cubierto los fundamentos y la práctica de las Cadenas de Markov. Sin embargo, las posibilidades de aplicación son vastas. Un área particularmente útil e interesante es la predicción a corto plazo. Para explorar cómo utilizar las Cadenas de Markov para anticipar el futuro inmediato y tomar decisiones basadas en probabilidades, te invitamos a leer nuestro artículo dedicado a la Predicción a Corto Plazo con Cadenas de Markov: Una Guía Paso a Paso.

Preguntas Frecuentes

¿Qué diferencia hay entre una Cadena de Markov y un Proceso de Markov?

Aunque a menudo se usan indistintamente, "Proceso de Markov" es el término más general que engloba cualquier proceso estocástico que cumple la propiedad de Markov, mientras que "Cadena de Markov" se refiere más específicamente a secuencias de estados en tiempo discreto o continuo. En la práctica, la distinción no siempre es crucial.

¿Es la propiedad de Markov una limitación importante en la práctica?

Depende del sistema modelado. Para muchos sistemas, la propiedad de Markov es una aproximación razonable y útil. Sin embargo, para sistemas con dependencias a largo plazo, modelos más complejos como los HMMs o redes neuronales pueden ser más apropiados.

¿Cómo se elige el número de estados en una Cadena de Markov?

La elección del número de estados depende del sistema que se modela y del nivel de detalle deseado. Un mayor número de estados puede proporcionar mayor precisión, pero también aumentar la complejidad del modelo y la necesidad de más datos para estimar las probabilidades de transición. A menudo es necesario encontrar un equilibrio.

¿Qué es una distribución estacionaria y por qué es importante?

La distribución estacionaria describe las probabilidades a largo plazo de estar en cada estado en una Cadena de Markov. Es importante porque nos da información sobre el comportamiento a largo plazo del sistema, independientemente del estado inicial.

¿Dónde puedo aprender más sobre Cadenas de Markov?

Existen numerosos recursos para aprender sobre Cadenas de Markov, incluyendo libros de texto de probabilidad y procesos estocásticos, cursos en línea (Coursera, edX, etc.), tutoriales en línea y la documentación de bibliotecas de software como pomegranate y hmmlearn.

Te Puede Interesar: